路遥工具箱今天迎来农历虎年(壬寅年)中第一次版本更新。本次更新除了对应用程序包进行常规升级之外,新增了“自然语言处理”频道。自然语言处理频道目前包含两个功能:中文分词和关键字提取。

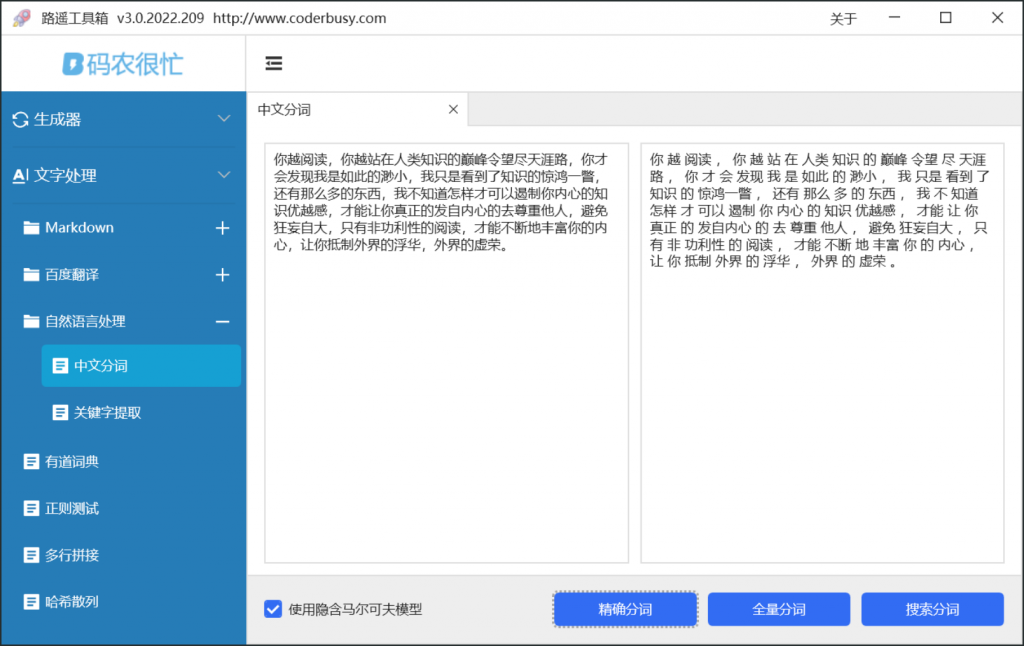

中文分词

分词就是将连续的字序列按照一定的规范重新组合成词序列的过程。我们知道,在英文的行文中,单词之间是以空格作为自然分界符的,而中文只是字、句和段能通过明显的分界符来简单划界,唯独词没有一个形式上的分界符,虽然英文也同样存在短语的划分问题,不过在词这一层上,中文比之英文要复杂得多、困难得多。

路遥工具箱作为一款为离线场景打造的工具,绝大部分功能在客户端完成。路遥工具箱使用 jieba.NET 作为分词组件,整合了:精确分词、全量分词和搜索分词三个功能。

- 精确分词:试图将句子最精确地切开,适合文本分析;

- 全量分词:把句子中所有的可以成词的词语都扫描出来, 速度非常快,但是不能解决歧义。具体来说,分词过程不会借助于词频查找最大概率路径,亦不会使用HMM;

- 搜索分词:搜索引擎模式,在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词。

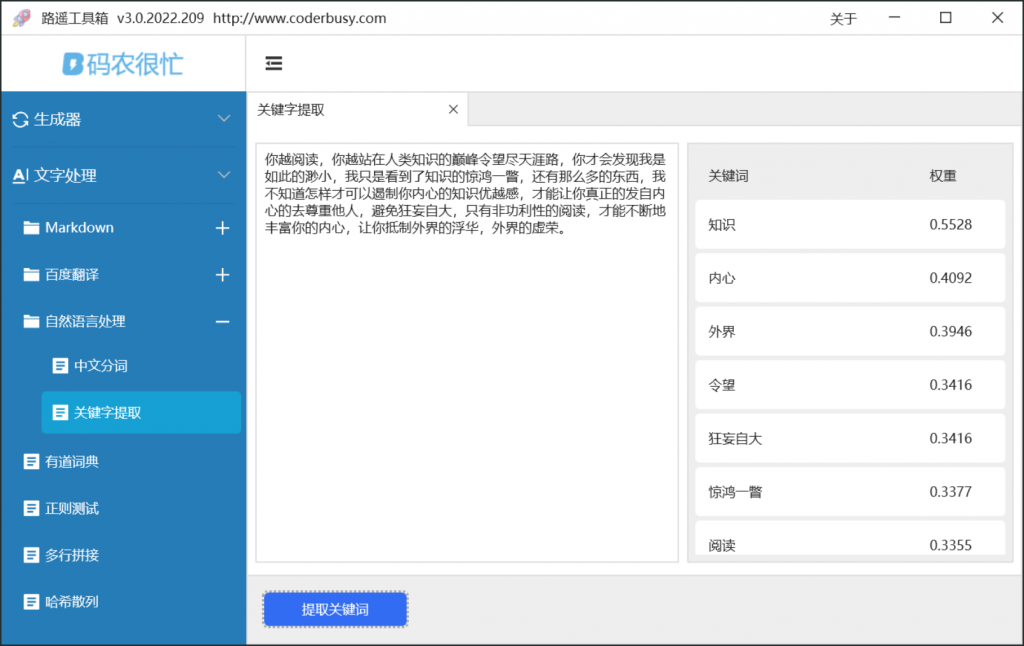

关键字提取

关键字提取是从文本文档中检索关键字或关键短语。 这些关键词从文本文档的短语中选择出来的并且表征了文档的主题。

路遥工具箱提供的关键字提取功能同样基于 jieba.NET 实现,底层采用了 TF-IDF 算法。在输入文本内容并点击“提取关键词”按钮后,工具箱会将提取到的关键词按权重从高到低展示出来。

路遥工具箱下载

路遥工具箱下载地址:https://www.coderbusy.com/luyao-toolkit